母狗 调教 翁荔,掌管OpenAI安全的北大学友,刚刚现身B站线下演讲

发布日期:2024-11-03 17:54 点击次数:103

衡宇 发自 夜深向阳母狗 调教

量子位 | 公众号 QbitAI

OpenAI研究副总裁(安全)翁荔(Lilian Weng),现身国内!

激情五月天还初度在国内大型步履场面公征战表AI主题演讲。

先浮浅先容一下,翁荔是OpenAI华东说念主科学家、ChatGPT的孝敬者之一。

北大毕业后,翁荔在2018年加入OpenAI,自后在GPT-4状貌中主要参与预检会、强化学习&对皆、模子安全等方面的处事。

最闻名的Agent公式也由她提议,即:Agent=大模子+记挂+主动磋商+器具使用。

在今晚的2024Bilibili超等科学晚步履上,翁荔站在舞台上,以《AI安全与“培养”之说念》为主题进行了演讲共享。

演讲并不十分艰深,主要以科普向为主,但深入浅出,先容了AI安全研究种种问题。

她暗意:

AI的安全不单是是研究者的职守,它需要每一个东说念主的参与。

(以下是翁荔演讲全文,在不转换其高兴的基础上略有删减。)

翁荔演讲全文今天先与群众商量一个既深切又酷爱的话题,「AI 安全」,以及「咱们怎样像培养下一代一样,莳植出理智又安全的东说念主工智能」。

ChatGPT横空出世以来,AI时刻如同搭乘了高速列车,连忙浸透并影响着咱们。

AI每天都在变化,需要咱们全心带领、证明注解,确保是更好的服务于东说念主类,同期确保安全。

一个既安全又智能的AI,无异于将为咱们的生计带来诸多裨益。

试想,一个知悉你生计俗例的智能家居系统,能字据你的需求自动迤逦室内温度、色泽;或是一个时刻关注你健康情景的AI助手,能为你提领提供量身定制的健康AI。

这不仅能显赫普及咱们的生计质地,还能开辟新的办事规模,普及处事成果。

但是,这一切建造在AI安全的基础之上。

正如自动驾驶时刻一样,它能极地面普及生计便利性,但是一朝出错,后果可能不胜遐想。

跟着AI应用日益智化与自主化,怎样确保AI的行动允洽东说念主类价值不雅,真实作念到以东说念主为本,成为了AI 安全与对皆研究等中枢议题。

东说念主类在成长过程中会不休学习跨越,但也会遭受成长的侵犯。

相似的,AI可能因为偏见而变得忐忑,也可能因为叛逆性挫折而被坏心质疑,AI安全和对皆研究能力使AI成长过程愈加顺利。

让咱们以健康规模为例。

好多疾病研究的数据时时以男性的群体为主,这可能导致AI在处理女性的健康问题时风险评估不准确。

此外,数据本人也有可能存在偏见。

比如有研究标明,女性腹黑病症状更容易被归结故意焦等热沈问题,而形成会诊遗漏。

因此,咱们需要通过对AI安全和对皆研究来减少偏见。

AI 学习的基础是数据,数据是它的食品。

要想让AI变得理智可靠,咱们必须确保它养分平衡,也等于提供它万般、全面、正确的数据,匡助它粗略正确地相识这个复杂的寰球,并减少偏差。

在使用东说念主类符号的数据时,咱们不错依赖于群体贤慧,也等于归并个数据点被多东说念主标注。

故酷爱的是, 1907年的一篇当然科学杂志中的著述,作家跟踪了一场年度博览会上的一个酷爱的有奖竞猜。

博览会上,东说念主们选出一头肥牛,让群众来料到牛的分量,最接近真实数据的东说念主将得回大额的奖金。

作家发现,「最中间值」时时是最接近真实数据。

这个数算计值也被称为the voice of the people。

在这篇近120年前的科学著述中,作家记忆说念:“我合计这个闭幕比东说念主们预期的更能评释民主判断真实度。”

这亦然最早提到群体贤慧怎样发生作用的科学文献。

而至于怎样把高质地标注的数据给AI,则基于东说念主类反映的强化学习(RLHF)起到了关键作用。

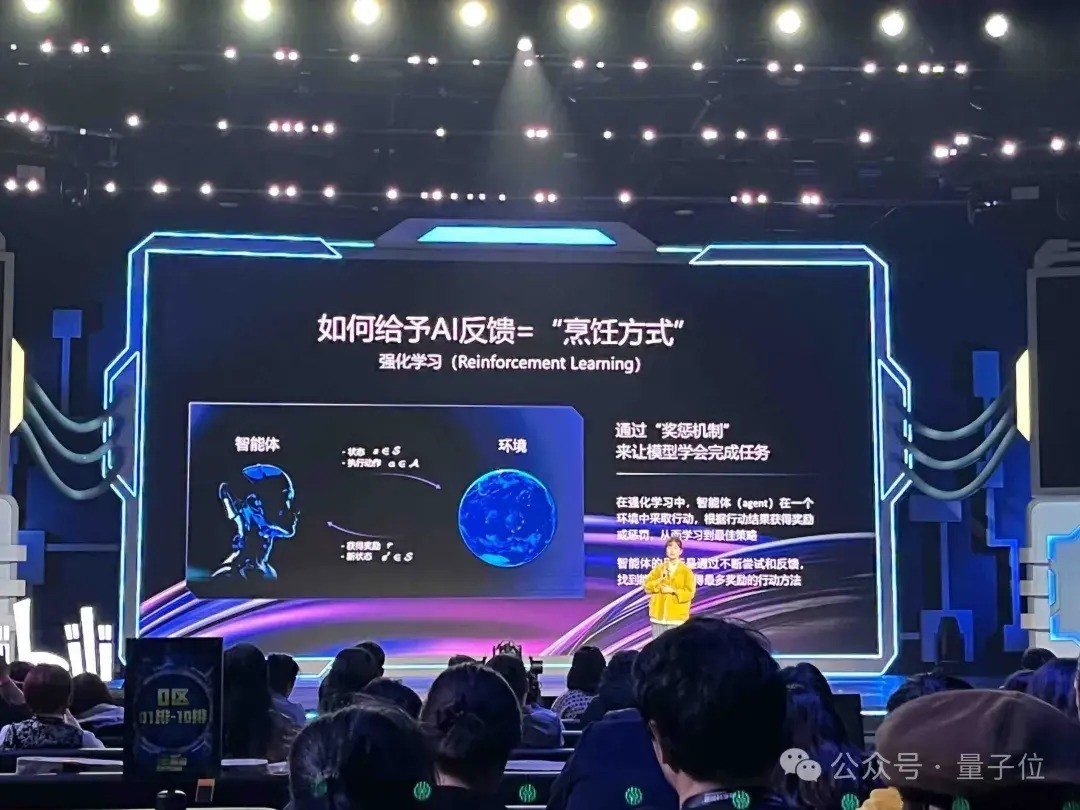

在了解RLHF之前,咱们快速了解一下什么是强化学习(RL)。

强化学习是一种机器学习门径,它主要通过赏罚机制来让模子学会完成任务,而不是依靠顺利告诉模子怎样去作念这件任务。

联想一下,就好像你检会小狗,淌若小狗作念对了一个动作,比如坐下,你就给他一块骨头饼干;作念错了就不给奖励。

这样,小狗就会因为想吃到更多的饼干而学会怎样正确地坐下。

同理,AI也在这种赏罚机制中学习,通过不休的尝试并得到反映,找到最好的服务战略。

一个早期的研究标明,强化学习能利用极少东说念主类反映,快速有用地造就智能体作念复杂的动作,学会怎样后空翻。

相似的门径也不错用于检会大说话模子(LLM)。

当咱们看到针对归并问题的不同AI修起时,咱们不错告诉模子哪一个修起更好、更正确、更允洽东说念主类价值不雅,这样咱们就像家长证明注解孩子一样,迤逦AI的学习过程。

此外,咱们还不错使用模子本人手脚AI输出质地的评分者。

比如在Antropic发表的《Constitutional AI》中,模子就通过对我方行动的我评价进行校正;或者在对皆强化学习中,咱们不错制定特地详备的行动表率来告诉AI,何时终止用户的申请,怎样抒发同理心等等。

然后咱们在强化学习的奖励机制中,特地精确地予以相应的评分奖励。

这个过程中,一个愈加强盛的AI有智商更精确地判断它是否顺从了东说念主类的价值不雅和行动准则。

强化学习时刻就像一把钥匙,匡助咱们怒放AI高质地学习和发展的大门。

在培养AI更懂咱们的过程中,等闲东说念主也能认知艰巨的作用。

在文档写稿上,咱们不错领受两个小手段。

最初,设定详备的布景和变装想想,像导演为演员准备脚本一样让AI在丰富的情境中,捕捉咱们的意图。

其次,全心挑选关键词,构建逻辑崭新的文档结构,使文档既好意思不雅又实用。

在视频音乐制作规模,咱们不错通过使用专科术语来带领AI,比如黄金分割构图或和弦进行,将创意迤逦为试验。

同期,别忘了情谊的参加,因为这是赋予作品灵魂关键词。

简而言之,通过致密的指导和情愫的融入,咱们不错匡助AI创作出既丰富又敷裕感染力的作品。

在《西纪行》中,孙悟空有紧箍咒管理行动,咱们应该给AI模子也戴上了紧箍咒,也等于造就 AI 安全基本准和说念德步调,让其遵从行动范例,以东说念主类利益为先,成为咱们贴心的伙伴,而不是冰冷的机器。

让AI学习基本原则和说念德准则,不错使模子在濒临复杂问题时哄骗推理得出正确的论断。

比如在OpenAI最近发表的Open-o1-preview模子中,咱们通过想维链(CoT)推理加强了模子的可靠性,使得模子不错更好地抵牾逃狱挫折。

彭胀性研究(scalable oversight)在AI对皆研究中也特地艰巨。

跟着AI模子扩大,需要相连自动化器具和东说念主类监督有用的行动,确保它朝着正确的地方发展。

在一组公开研究中,咱们用监督学习检会说话模子对荟萃文本摘记进行月旦,比如提供“这个摘记特地准确”,或者“这个摘记遗落重点”。

比较对照组,咱们发现存AI匡助的标注员比莫得匡助的能多找出摘记中约50%的问题,何况多量参考了模子提供的骨子。

总之,给AI设定步调并进行有用监督,不错普及它对东说念主们的匡助。

AI的安全不单是是研究者的职守,它需要每一个东说念主的参与。

以B站为例,这个充满活力的社区皆集了繁密AI能干者、创作家,咱们在这里共享方便、盘问问题,以至监督AI的清晰,共同影响着 AI 的成长。

咱们每个东说念主都应该成为AI的群众长。

AI 时刻是一把双刃剑,它带来的便利和挑战并行,咱们的参与至关艰巨。

让咱们联袂培养出一个既理智又认知的AI伙伴。

感谢群众的凝听,但愿今天的共享激励群众对AI安全的矜恤酷爱,也感谢B站直播这个平台。

让咱们共同为AI的异日孝敬力量,谢谢。

OpenAI备受争议的安全之路但是,OpenAI在安全这个地方的前进,却一直备受争议。

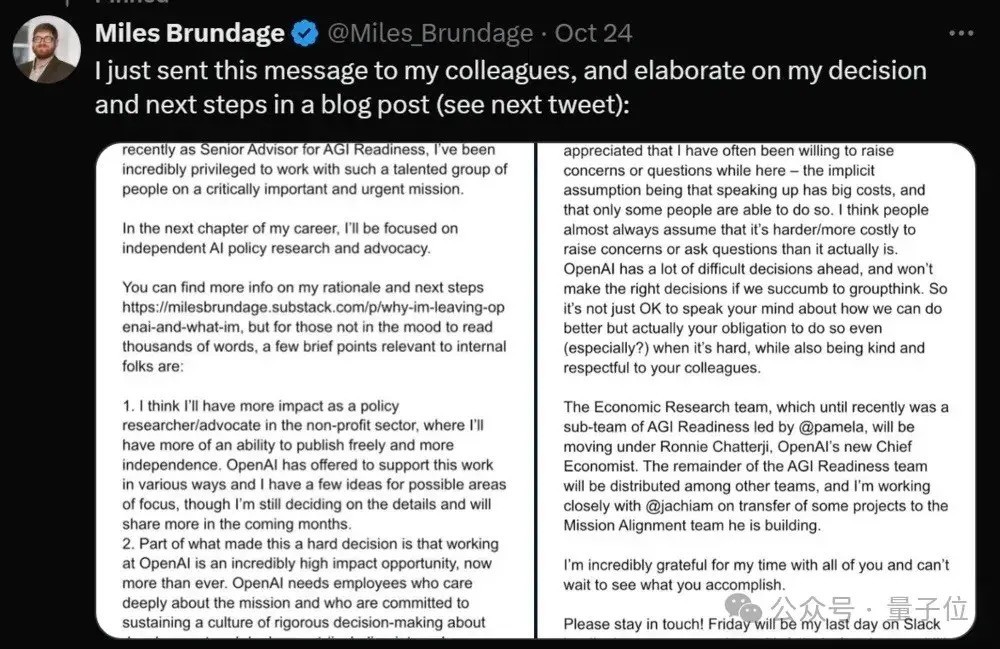

上周,一则“OpenAI终结AGI筹备团队”的音书传遍全球。

源流是AGI Readiness团队认知东说念主Miles Brundage晓谕下野。

他暗意,已在OpenAI完成通盘处事,在外部处事将产生更大的影响。

异日他宗旨在OpenAI除外不息从事该规模研究处事,并但愿减少偏见。

这不是OpenAI安全方面离开的唯独一个艰巨东说念主物。

本年上半年,OpenAI调处独创东说念主、首席科学家Ilya Sutskever下野,他带领的“超等对皆团队”未必终结。

该团队设立于2023年7月,OpenAI给了它一个责任:

用20%的算力,在异日4年内处理截至超等智能AI的中枢时刻挑战。

Ilya是这样解释我方离开OpenAI的原因的:

制造比东说念主类更理智的机器本人等于一项危机的职业。

OpenAI代表全东说念主类肩负着弘大的职守。但在往时几年里,安全文化和历程如故让位于闪亮的家具。审定离开的还有“超等对皆”团队调处认知东说念主、安全主宰Jan Leike——他最终遴荐跳槽到OpenAI最强竞对、Claude背后团队Anthropic,不息超等对皆处事。

下野后,Leike对外爆料,最近几年OpenAI如故不吝里面文化,把“眩惑眼球的家具”放在安全准则之前。

当今,翁荔无疑是是最前沿AI实验室的安全总认知东说念主了。

OpenAI的安全之路,又将走向何方?

— 完 —

量子位 QbitAI · 头条号签约

关注咱们母狗 调教,第一时候获知前沿科技动态